Introducción

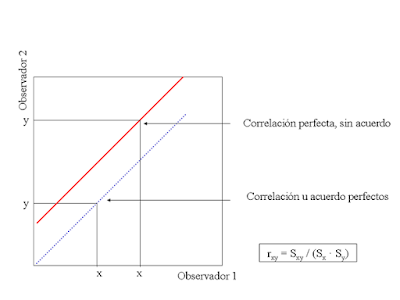

En un artículo previo se trató la manera en que debe analizarse la reproductibilidad de pruebas diagnósticas cuando la variable medida se trataba de una de tipo cualitativo (por ejemplo positivo/negativo, escalas de ordenación, etc). En el presente artículo se estudiará la manera en que deberíamos hacerlo cuando se trata de variables cuantitativas. En estos casos podemos analizar la consistencia interna de la prueba (mediante el coeficiente de correlación intraclase de consistencia), y del acuerdo entre observadores (mediante la determinación del coeficiente de correlación intraclase de acuerdo o mediante métodos gráficos).Dos errores frecuentes a la hora de valorar la reproductibilidad de este tipo de pruebas es recurrir al coeficiente de correlación o a la T de Student pareada. Debemos recordar que el coeficiente de correlación determina si la nube de puntos que generan las determinaciones de dos observadores se ajusta bien a una recta. De esta manera dos observadores pueden generar una nube de puntos que se ajuste de forma perfecta a una recta (r = 1), y que exista o no acuerdo entre ellos. Lo vemos en la siguiente figura. La línea de puntos azul se corresponde con dos observadores con acuerdo perfecto (x siempre es igual a y); por el contrario la línea roja, con una correlación también perfecta, no presenta acuerdo entre observadores.

Por su parte la T de Student pareada es una prueba paramétrica y está basada en la media y error estándar de las diferencias de medición entre dos observadores, siendo la hipótesis nula que la media de diferencias es 0. La prueba tiene como limitación que cuanto mayor sean las diferencias en valor absoluto mayor será el error estándar y más difícil será encontrar significación para un mismo tamaño muestral. Hay que recordar para entender esto, que el rechazo de la hipótesis nula se basa en encontrar un valor absoluto de z mayor que 1,96 para una confianza del 95% en la fórmula

Reproductibilidad

Coeficientes de correlación intraclase

El método más adecuado para analizar la reproductibilidad en esta situación es la determinación de los coeficientes de correlación intraclase (CCI). Supongamos el siguiente ejemplo sobre la determinación de la glucemia capilar en 10 sujetos con 5 observadores:| Observador 1 | Observador 2 | Observador 3 | Observador 4 | Observador 5 | |

|---|---|---|---|---|---|

| 1 | 155 | 157 | 165 | 162 | 163 |

| 2 | 230 | 225 | 240 | 225 | 218 |

| 3 | 175 | 184 | 185 | 181 | 190 |

| 4 | 300 | 297 | 310 | 295 | 290 |

| 5 | 235 | 230 | 245 | 230 | 225 |

| 6 | 125 | 132 | 135 | 132 | 139 |

| 7 | 130 | 125 | 140 | 135 | 130 |

| 8 | 189 | 184 | 199 | 184 | 179 |

| 9 | 291 | 296 | 301 | 296 | 301 |

| 10 | 305 | 310 | 315 | 295 | 300 |

| Media | 213,5 | 214 | 223,5 | 213,5 | 213,5 |

| Varianza | 4290,45 | 4290 | 4290,45 | 3787,85 | 3795,85 |

- CCI de consistencia (CCIc): Tiene en cuenta la variabilidad debida al los sujetos de estudio y la debida al azar, no teniendo en cuenta la variabilidad debida a los observadores. Se mide por tanto el comportamiento de la prueba en los sujetos de estudio.

- CCI de acuerdo (CCIa): Tiene en cuenta la variabilidad debida al los sujetos de estudio, la debida al azar, y la debida a los observadores

- Normalidad

- Homocedasticidad (varianzas homogéneas)

- Independencia

Volviendo al ejemplo, entre los observadores 1 y 2 no encontramos diferencias en la media ni en la varianza, por lo que probablemente no exista variabilidad interobservador y CCIc y CCIa tendrán un valor similar. Ocurre lo mismo con los observadores 4 y 5, pero en este caso la varianza es menor, por lo que el numerador de los CCI también será menor así como su resultado final: los CCI son muy dependientes de la variabilidad en la medición en una población concreta además del azar, pudiendo no ser comparables CCI hallados a partir de diferentes poblaciones. Entre los observadores 1 y 3 hay diferencias de media pero no de varianza (en este caso porque el segundo siempre encuentra valores superiores al primero). Los observadores no son comparables mediante CCI pues las varianzas no son homogéneas.

Para el cálculo de los CCI procederemos al cálculo de las tablas correspondeintes de un ANOVA de un factor con muestras repetidas. En el caso del ejemplo expuesto:

| O1 | O2 | O3 | Medias | Cuadrados | |

|---|---|---|---|---|---|

| 1 | 155 | 157 | 165 | 159 | (159 - 217)2 = 3364 |

| 2 | 230 | 225 | 240 | 231,66 | (231,66 - 217)2 = 215,11 |

| 3 | 175 | 184 | 185 | 181,33 | 1272,11 |

| 4 | 300 | 297 | 310 | 302,33 | 7281,11 |

| 5 | 235 | 230 | 245 | 236,66 | 386,77 |

| 6 | 125 | 132 | 135 | 130,66 | 7453,44 |

| 7 | 130 | 125 | 140 | 131,66 | 7281,77 |

| 8 | 189 | 184 | 199 | 190,66 | 693,44 |

| 9 | 291 | 296 | 301 | 296 | 6241 |

| 10 | 305 | 310 | 315 | 310 | 8649 |

| Medias | 213,5 | 214 | 223,5 | 217 | suma x 10 filas = 128515,33 |

| Cuadrados | (213,5 - 217)2= 12,25 | (214 - 217)2 = 9 | (223,5 - 217)2 = 42,25 | suma x 3 columnas = 635 |

Nos queda plantear la tabla resumen:

| Suma de cuadrados | gdl | Cuadrados medios (SC/gdl) | CCIc | CCIa | |

|---|---|---|---|---|---|

| Observadores | 635 | 3-1 = 2 | 317,5 | 0,99 | 0,99 |

| Sujetos | 128515,33 | 10-1 = 9 | 14279,48 | ||

| Azar | 193,67 | 2 x 9 = 18 | 10,76 | ||

| Total | 129344 | 29 |

Métodos gráficos

Otra forma de analizar el grado de acuerdo entre dos fuentes de medidas es el métodp gráfico de Altman y Bland, que tiene como requisito que las mediciones se distribuyan según una distribución normal. Se trata de un gráfico de nube de puntos contruido a partir de parejas de mediciones de dos observadores; cada X se corresponde con la media de las dos mediciones, y su correspondiente Y es su diferencia. El acuerdo perfecto vendrá dado por la coincidencia entre la recta de regresión de la nube de puntos y el eje X (panel A, CCIc = CCIa = 0,99); una recta paralela al eje X indica consistencia pero desacuerdo por diferencia aditiva constante entre los dos observadores (panel B, CCIc = 1, CCIa = 0,98); por el contrario una recta de regresión con pendiente refleja una relación entre la medición y el grado de desacuerdo entre los observadores (diferencia proporcional al valor absoluto de la medición) (paneles C y D).Comparación de dos métodos analíticos

En ocasiones podemos necesitar analizar si existen errores sistemáticos en las determinaciones de dos sistemas de medida diferentes. Supongamos que tenemos dos métodos A y B, podríamos teorizar que las medidas realizadas con el método A son- Método de Deming (paramétrico, supone normalidad y homogeneidad de varianzas):

- Método de Passing y Bablock (no paramétrico): Es el método de lección. Se obtienen todas los posibles puntos formados por las N mediciones de A y B; luego se determinan todas las posibles parejas de puntos (½ N x [N-1] parejas); cada pareja de puntos formará una recta de la que determinaremos su pendiente ([Ai-Aj]/[Bi-Bj]); para cada pareja de puntos y a partir de la pendiente hallada determinaremos su ordenada en el origen(oi = Ai - pi x Bi); β será la mediana de todas las pendientes mayores de -1; α será la mediana de las ordenadas en origen.

Ficha bibliográfica

- Título:

- Análisis de pruebas diagnósticas (II): Reproductibilidad con variables cualitativas y comparabilidad de dos métodos analíticos

- Dirección:

- http://epidemiologia-estadistica.blogspot.com.es/2013/02/analisis-de-pruebas-diagnosticas-ii.html

- Descripción:

- Se estudian los índices con los que puede analizarse la reproductibilidad de una prueba diagnóstica y su interpretación, cuando dicha prueba nos ofrece el resultado en forma de una variable cuantitativa.

- Palabras clave:

- reproductibilidad, validez, pruebas diagnósticas

- Código de idioma:

- es

- Autor/a:

- Fco. Javier Caballero Granado

- Editor/a:

- Fco. Javier Caballero Granado

- Derechos:

- Fco. Javier Caballero Granado

- Fecha de creación:

- 2010-11-03

- Fecha de modificación:

- 2010-11-10

- Forma parte de:

- Notas sobre estadística

- Cómo citar:

- Caballero-Granado FJ. Análisis de pruebas diagnósticas (II): Reproductibilidad con variables cualitativas y comparabilidad de dos métodos analíticos [en línea]. Sociedad Andaluza de Enfermedades Infecciosas Ed. Creado el 03/11/2010; actualizado el 2010-11-10 . Disponible en web: http://epidemiologia-estadistica.blogspot.com.es/2013/02/analisis-de-pruebas-diagnosticas-ii.html [consultado el ...]